SUSEのエンタープライズコンテナ管理スタックとNVIDIA NIMで生成AIの導入をシンプルに

概要

生成AI(gen AI)は企業に旋風を巻き起こしています。 使用例としては、コンテンツ作成、製品設計開発、顧客サービスなどが挙げられます。 企業は、効率性と生産性の向上、創造性と革新性の強化、顧客体験の向上、開発コストの削減を実現できます。

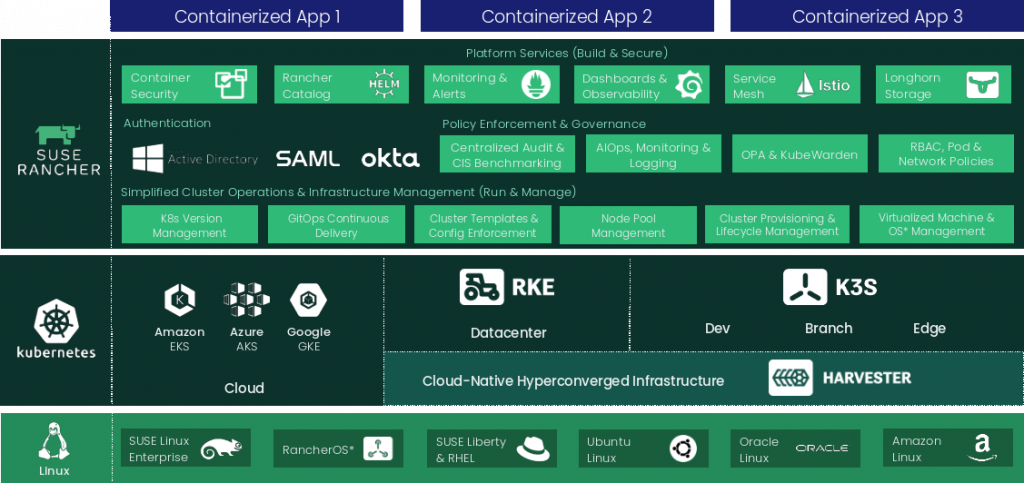

SUSEのエンタープライズコンテナ管理(Enterprise Container Management)製品(Rancher Prime、Rancher Kubernetes Engine 2、Longhorn、NeuVector)とNVIDIA NIM推論マイクロサービスを組み合わせることで、パートナーやお客様は、迅速な開発サイクル、効率的なリソース利用、より容易なスケーリングにより、生成AIの導入を加速することができます。

SUSE エンタープライズコンテナ管理スタック

本稿では、以下に焦点を当てます:

- 生成AIの基本定義

- 企業における生成AI活用の現状

-生成AIの導入に影響を与えるニーズ(要件)と課題 - SUSEのECMスタックとNVIDIA NIMの組み合わせが、上記のニーズと課題にどのように対応するか

- 今後の展望 – SUSE ECM製品とNVIDIA NIMの次のステップについて

生成AIとは – 基本定義

「生成AIとは、テキスト、画像、音声、合成データなど、さまざまな種類のコンテンツを生成できる人工知能技術の一種である」[1]。 特定のデータセットについて予測を行うのではなく、新しいデータを作成するように訓練された機械学習モデル」と考えることができる。 生成AIシステムとは、訓練されたデータに似たオブジェクトをより多く生成するように学習するシステムである」[2]。

企業における生成AIの現在

生成AIは企業内で急成長している状態ですが、まだ導入の初期段階であることは言うまでもありません。

Deloitte の第2四半期生成AIレポート[3]によると、「企業は価値の創造を優先し、生成AIの取り組みから具体的な成果を求めている」といいます。 そのためには、生成AIの導入規模を拡大し、実験、試作、概念実証を超えて前進する必要がある」と述べています。最も重要な課題の2つは、信頼の構築 (生成AIの信頼性と信用性を高めるという観点)と、労働力の進化 (AIが労働者のスキル、役割、人員に与える潜在的な影響への対応)です。

初期のユースケースには以下のような分野が含まれます:

- コンテンツ作成: 生成AIは、提供されたインプットや スタイルガイドラインに基づいて、マーケティングコピー、ソーシャルメディアへの投稿、製品説明、さらにはスクリプトを作成することができます。

- 製品設計と開発: AIは、既存のデータやユーザーの嗜好に基づいて、新製品のアイデア、製品バリエーション、試作品を生成することができます。

- カスタマーサービス・チャットボット: 日常的なカスタム問い合わせを処理するAIチャットボット。

さらに2つの技術分野があります:

- データ増強: 実データが乏しかったり、機密性が高かったりするような状況で、機械学習モデルを訓練するための合成データを生成するAI。

- 創薬と材料科学: 生成モデルは、特定の特性を持つ医薬品や材料の新しい分子を設計し、研究開発時間を短縮することができます。

Deloitteのレポートに記載されているビジネスの優先順位と初期のユースケースを組み合わせると、以下のような要件と課題に行き着きます。

要件:

- 価値創造を加速し、具体的な成果をもたらすための、生成AIモデルの迅速な開発

- 既存のアプリケーションにAIモデルを統合することを可能にする統合の簡素化。

- 企業がデータを安全に保護できるよう、セキュリティとデータプライバシーを強化。

- ニーズの変化に応じてオンデマンドで拡張可能。

- 企業独自のデータを組み込んでモデルをカスタマイズする能力。

課題:

- 技術的専門知識: 生成AIモデルの実装と維持には、専門的なスキルとリソースが必要であり、すべての企業で利用できるとは限りません。

- データの品質とバイアス:生成モデルは、学習させたデータと同程度の性能しか持ちません。 高品質で偏りのないデータを確保することは、誤解を招いたり、攻撃的な出力を生成することを避けるために極めて重要です。

- 説明のしやすさと信頼性: 生成モデルがどのようにアウトプットに到達したかを理解することは困難な場合があります。 これは、特に重要なアプリケーションにおいて、信頼性と透明性に関する懸念を引き起こす可能性があります。

- セキュリティとコントロール: ディープフェイクや悪意のあるコンテンツの作成など、生成AIモデルに関連する潜在的なセキュリティリスクの軽減は、継続的な懸念事項です。

SUSE ECM StackとNVIDIA NIMで企業向け生成AIの要件に対応

NVIDIA NIMをSUSE エンタープライズコンテナ管理スタックと組み合わせて導入することで、生成AIアプリケーションの開発と本番導入の両方に理想的なDevOpsミックスを提供します。

NVIDIA NIMとNVIDIA AI Enterprise

NVIDIA NIMは、NVIDIA AI Enterpriseソフトウェアプラットフォームを通じて利用できます。これらの構築済みコンテナは、オープンソースのコミュニティモデルからNVIDIA AI Foundationモデル、さらにはカスタムAIモデルまで、幅広いAIモデルをサポートします。NIMマイクロサービスは、標準的なAPIとわずか数行のコードを使用して、エンタープライズグレードのAIアプリケーションに簡単に統合できるように、1つのコマンドで展開されます。NVIDIA Triton Inference Server、NVIDIA TensorRT、NVIDIA TensorRT-LLM、PyTorchなどの推論エンジンを含む堅牢な基盤の上に構築されたNIMは、シームレスなAI推論をスケールアップできるように設計されており、ユーザーが安心してAIアプリケーションをどこにでも展開できることを保証します。オンプレミスでもクラウドでも、NIMは生成的なAI推論を大規模に高速化する最速の方法です。

課題対処方法:

| 課題 | NVIDIA NIMとNVIDIA AI Enterpriseがどのように課題に対処し、軽減するかを説明します。 |

| 企業における技術的専門知識 | 構築済みのコンテナとマイクロサービスにより、複雑なインフラストラクチャの構築と保守に関する豊富な専門知識を持たない開発者でも、デプロイメントを簡素化することができます。 |

| データの品質と偏り | 十分にテストされた承認済みモデルのプロセスを簡素化することで、企業はモデルに使用するトレーニングデータの品質確保にリソースを集中させることができます。 |

| 説明可能性と信頼性 | NIMはモデルのバージョニングをサポートしており、ユーザーは更新履歴を追跡し、特定のタスクに同じモデルバージョンを使用できるようにします。

依存関係と実行環境を管理することで、NIMはモデルが一貫した環境で実行されることを保証し、外部要因による出力のばらつきを低減します。 |

| セキュリティと制御 | NIMは強力な認証メカニズムをサポートし、ロールベースのアクセス制御(RBAC)の実装を可能にします。

NIMはモデルの使用に関連するすべてのアクティビティを記録することができます。 |

SUSE エンタープライズコンテナ管理スタック(SUSE ECMスタック)

SUSE エンタープライズコンテナ管理スタックは業界ではよく知られています。 Rancher Prime、Rancher Kubernetes Engine 2 (RKE2)、Longhorn、NeuVector Primeの組み合わせでNVIDIA NIMをデプロイする場合、以下のようなメリットが考えられます。

- Rancher Primeは、Kubernetesクラスタのデプロイと管理を簡素化するエンタープライズKubernetes管理プラットフォームです:

- 集中管理により、複数のKubernetesクラスタを一画面にまとめて管理でき、異なる環境間で一貫した設定とポリシーの適用を実現します。

- Rancher Primeは、NVIDIA NIMで実行されるような大規模なAIワークロードの要件を満たすために、Kubernetesクラスタのスケーリングを容易にします。

- マルチクラスタのサポートにより、クラウドプロバイダーとオンプレミス環境にまたがる展開が可能になり、柔軟性と冗長性が提供されます。

- RKE2は、本番環境に最適化された軽量な認定Kubernetesディストリビューションです。

- インストールおよび設定プロセスが合理化され、NIMの導入と管理が容易になります

- CIS BenchmarkやSELinux(ノード上)など、すぐに使えるセキュリティ機能をサポートします。

- Longhornは、Kubernetes向けのクラウドネイティブな分散ブロックストレージソリューションです。

- AIモデルに必要なようなデータのための可用性の高い複製ストレージを提供し、データの耐久性と耐障害性を確保します。

- AIワークロードの増加に伴うストレージ需要に対応するために容易に拡張でき、生成AIで一般的に使用される大規模データセットをサポートします。

- NeuVectorは、包括的なコンテナセキュリティを提供するKubernetesネイティブのセキュリティプラットフォームです。

- AIワークロードの脅威や異常に対するコンテナ監視を実行するためのランタイムセキュリティ。

- 高度なネットワークセグメンテーションとファイアウォール機能を提供し、インフラストラクチャの異なるコンポーネント間の通信を保護します。

- コンテナアクティビティに対する可視化と制御により、セキュリティ標準へのコンプライアンスの維持を支援します。

- コンテナイメージの脆弱性をスキャンし、安全なイメージのみがデプロイされるようにします。

SUSE ECMスタックのコンポーネントとNVIDIA NIMを組み合わせることで、お客様は次のようなメリットを享受できます:

- セキュリティの強化 – RKE2のセキュアな設定、NeuVectorのランタイムセキュリティ、および脆弱性管理により、AI環境は脅威や不正アクセスから十分に保護されます。

- 高可用性と信頼性 – Longhornはストレージの高可用性と信頼性を保証し、データ損失やダウンタイムを防ぎます。

- スケーラビリティ: Rancher PrimeとLonghornは、NIMの要件が企業内で必要とされる規模の拡張性をクラスタ間で提供します

- 管理の簡素化: Rancher Primeは一元化されたKubernetes管理プラットフォームを提供し、クラスタのスケールと一貫したポリシーと設定の確保を容易にします。

- パフォーマンス – RKE2とLonghornは高いパフォーマンスを実現するために最適化されており、NIMの効率的な実行と集中的なAIタスクの処理を保証します。

- 柔軟性と互換性: SUSE ECMスタックはKubernetesと互換性があるため、さまざまなツールやサービスとの統合が可能で、導入オプションに柔軟性があります。

まとめると、SUSE ECMスタックは、NVIDIA NIMに堅牢で安全かつスケーラブルなインフラストラクチャを提供します。 このスタックを組み合わせることで、生成AIのデプロイメントのセキュリティ、管理性、パフォーマンスが強化され、NIMを本番環境で効率的にデプロイして運用できるようになります。

今後の展望 – 使いやすい構成で統合を実現。

近い将来、NVIDIA NIM on SUSE Enterprise Container Management Guideを提供し、お客様とパートナーにメリットをもたらすコンポーネントのまとめ方を文書化する予定です。このドキュメントでは、Rancherクラスタの構築、RKE2、Longhorn、NeuVectorのインストールとデプロイ、NVIDIA AI EnterpriseとNIMのワークロードとしてのデプロイ方法を紹介する予定です。 SUSEのブログまたはソーシャルメディアを通じて、さらなる利用可能性に関するアナウンスにご期待ください。

[1] https://www.techtarget.com/searchenterpriseai/definition/generative-AI

[2] https://news.mit.edu/2023/explained-generative-ai-1109

[3] https://www2.deloitte.com/content/dam/Deloitte/us/Documents/consulting/us-state-of-gen-ai-report-q2.pdf

Related Articles

2月 27th, 2024

選択は重要です。SUSEは選択肢を提供します。

12月 12th, 2023

SUSE Linux Enterprise Server、Intel® TDXのサポートを開始

1月 03rd, 2023

未来のデジタルファースト・エンタープライズにおけるオープンソース・ソフトウェアの重要性

7月 11th, 2023